動かなくなったコードを必死に修正指示するバイブコーダーが読むべき研究結果

公開日

GitHubの報告によると、現在92%以上の開発者がAIコーディングツールを使用しており、ソフトウェア開発の現場は「コードを書く」作業から「AIが生成した解決策を評価・選定する」作業へと大きく変化しています。しかし、この新しいプロセスにおいて、私たちは本当に合理的な判断ができているのでしょうか。AIの提案を鵜呑みにしたり、検証がおろそかになったりすることで、かえって手戻りが増えていると感じることはありませんか。

本記事では、南カリフォルニア大学やGitHub Researchなどの研究チームが2026年の国際会議(ICSE ‘26)に向けて発表した論文「Cognitive Biases in LLM-Assisted Software Development」に基づき、AIプログラミング特有の落とし穴とその回避策について解説します。

調査の概要:LLMは開発者の意思決定をどう変えたか

本研究では、LLM(大規模言語モデル)を使用した開発プロセスにおいて、開発者がどのような認知バイアスに影響されているかを明らかにするため、綿密な観察調査が行われました。調査は、3年以上の経験を持つ学生およびプロフェッショナルな開発者14名を対象に、計2,013件の開発アクション(そのうち808件がLLMとの対話)を分析するというものです。さらに、結果の妥当性を確認するために22名の開発者への追加調査も実施されています。

研究チームは、開発者の行動をビデオ記録し、「コードの記述」「LLMへの質問」「提案の採用」といったアクションごとに、心理学の専門家と協力して特定した90種類のバイアスとの関連を分析しました。これにより、従来の開発にはなかった、AIペアプログラミング特有の課題が見えてきました。

衝撃の事実:LLM利用時は「認知バイアス」が激増する

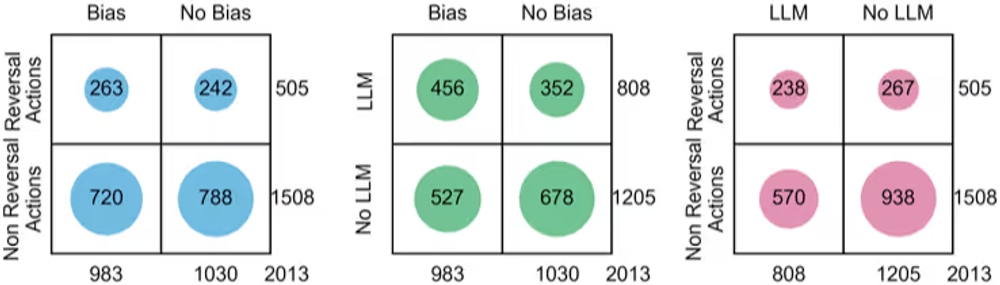

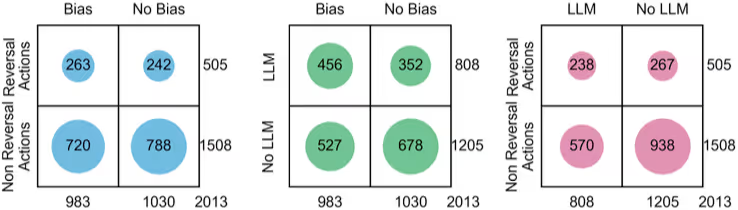

調査の結果、開発者の行動の約半数にあたる48.8%(983件)が何らかの認知バイアスの影響を受けていることが判明しました。中でも特筆すべきは、LLMに関連するアクションの56.4%(456件)にバイアスが含まれていたという事実です。これは、LLMを使用していない時のアクションと比較して統計的に有意に高い数値です。

図表1:バイアスと手戻りアクションの分布 (左)全体、(中央)LLM有無別、(右)LLMと手戻りの関係)

図表1:バイアスと手戻りアクションの分布 (左)全体、(中央)LLM有無別、(右)LLMと手戻りの関係)

さらに深刻なのが、図表1(右)に示された「手戻り(Reversal Actions)」の実態です。 LLMに関連するアクションの約30%(238件)が、後に作業の取り消しややり直しとなっています。

これは、AIが提示したコードを安易に採用した結果、後になってバグや仕様の不一致が発覚し、修正に追われていることを意味します。AIによって表面的なコーディング速度は上がっても、判断の質が低下することで、結果的に開発効率を落としてしまっている可能性があるのです。

開発者を惑わす「主要な認知バイアス」の正体

では、具体的にどのようなバイアスが開発者を誤った判断へと導いているのでしょうか。研究チームは、LLMとの対話における90のバイアスを15のカテゴリに分類しました。ここでは、特に頻度が高く、開発への悪影響が大きい代表的なものを紹介します。

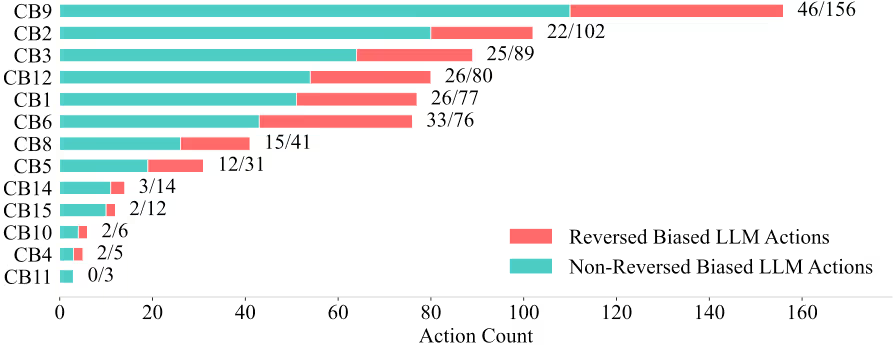

図表2:カテゴリ別のバイアス発生頻度と手戻りの割合

図表2:カテゴリ別のバイアス発生頻度と手戻りの割合

安易な解決を求めてしまう「目先の優先」

図表2で最も発生頻度が高い(赤と青のバーの合計が最大)のが、この「目先の優先」バイアス(CB9)です。これは、将来的な保守性や品質のリスクを無視して、目の前の「とりあえず動くコード」や「手っ取り早い解決策」に飛びついてしまう傾向を指します。 例えば、LLMが提示したコードのロジックを完全には理解していないにもかかわらず、エラーが出ずに実行できたという理由だけで採用してしまうケースがこれに当たります。

AIを過信し検証を怠る「提案者への過信」

2番目に多かったのが、提案者(この場合はLLM)の権威やシステム性を過信し、無批判に受け入れてしまうバイアス(CB2)です。AIが自信満々に提示するコードや、もっともらしい解説を見ると、開発者は自分の判断よりもAIの出力を優先してしまう傾向があります。たとえ自分の中に「これはおかしいのでは?」という疑念があっても、それを打ち消してAIに従ってしまうのです。

初期案に固執してドツボにはまる「固執」

手戻りにつながる割合が最も高かった(43.4%)のが「固執」バイアス(CB6)です。これは、最初に得られた情報やアプローチに固執し、状況が変わっても柔軟に考えを変えられない状態です。 例えば、LLMがあるライブラリを使った解決策を提示し、それが上手くいかない場合でも、別の方法を検討するのではなく、ひたすらそのライブラリを使った修正案をLLMに聞き続けて時間を浪費する、といった行動が観察されました。

バイアスを回避し、AIを使いこなすための具体的対策

これらのバイアスは無意識のうちに発生するため、完全に防ぐことは困難です。しかし、研究の参加者への調査から、有効な対策やツールが見えてきました。

プロンプト入力前の準備:AIは「ツール」と割り切る

まず重要なのは、マインドセットです。AIを「答えを知っている先生」ではなく、「限定的な機能を持つツール」として捉えることが、過信や固執を防ぐ第一歩です。

- タスク分解と要件定義: いきなりコードを書かせるのではなく、要件を明確にし、タスクを小さく分解してからAIに指示を出します。

- テスト駆動開発(TDD): AIにコードを書かせる前に、まずテストケースを作成します。これにより、AIの生成コードが要件を満たしているかを客観的に判断でき、「目先の優先」による質の低いコードの採用を防げます。

生成結果の評価時:疑う姿勢を持つ

AIの回答は、必ずしも最適解ではありません。

- 代替案の模索: 最初に提示されたコードに飛びつくのではなく(固執の回避)、「他の方法は?」「別のライブラリを使うとどうなる?」と問いかけ、複数の選択肢を比較検討します。

- ドキュメントとの照合: AIが提示したAPIやメソッドが本当に存在し、正しい使い方なのか、公式ドキュメントで裏付けを取る習慣をつけます。

ツールの活用

人間の認知能力には限界があるため、ツールによる補助も有効です。

- 静的解析ツール(Linter): AIが生成したコードの潜在的なバグやスタイル違反を自動的に検出します。

- 差分比較ツール: 生成コードと既存コードの差分を可視化し、意図しない変更が含まれていないかを確認します。

結論

LLMは強力な開発パートナーですが、同時に私たちの判断力を鈍らせる「認知バイアス」の発生源にもなり得ます。本研究が明らかにしたように、AIを使用したアクションの半数以上にバイアスが潜んでおり、それが手戻りの原因となっています。

しかし、これはAIを使うべきではないという意味ではありません。「自分はバイアスにかかっているかもしれない」と常に自問し、テスト駆動開発やドキュメント確認といった基本的なエンジニアリングプラクティスを徹底することで、バイアスの影響を最小限に抑えることができます。AIの出力結果をただ受け取るのではなく、主体的に評価・選別する能力こそが、これからの開発者に求められる最も重要なスキルと言えるでしょう。

開発生産性やチームビルディングにお困りですか? 弊社のサービス は、開発チームが抱える課題を解決し、生産性と幸福度を向上させるための様々なソリューションを提供しています。ぜひお気軽にご相談ください!

参考資料: